Uncategorized

22 de abril de 2024

EL JUEZ TERMINATOR 2

¿El juicio final?

Por Nicolás Lozada Pimiento, CEO de Redek y Profesor Titular de la Universidad Externado de Colombia

“El futuro es lo que uno hace de él”

En el clásico de la ciencia ficción Terminator 2: El juicio final (Cameron, 1991), el robot exterminador T-800 (interpretado icónicamente por Arnold Schwarzenegger) viaja al pasado para evitar que otro exterminador, más avanzado y de metal líquido (interpretado por un terrorífico Daniel Patrick uniformado de policía), asesine a John Connor; el único hombre que podía salvar a la humanidad. Por supuesto, alarmados, los humanos protagonistas de la película hacían todo lo posible por detener la amenaza de la inteligencia artificial (en adelante IA) en medio de disparos, persecuciones y explosiones.

Persecución de los dos Terminators. Tomada de Cameron, James. (1991). Terminator 2: EL juicio final.

Con la popularización del ChatGPT, un sector de la sociedad considera que el juicio final de la IA les ha llegado a los jueces. Podemos evidenciar las decisiones de los jueces de Cartagena (Juzgado 1 Laboral del circuito de Cartagena, 2023) y lo mencionado en el Tribunal Administrativo del Magdalena en Colombia (Tribunal Administrativo del Magdalena, 2023), y más recientemente de

la Corte Superior de Justicia de Lima Sur (Corte Superior de Justicia de Lima sur, 2023). Adicionalmente, la Sala Constitucional Cuarta de Santa Cruz en Bolivia, ha citado textos producidos con prompts de ChatGPT. Los anteriores ejemplos parecen sugerir que la judicatura empieza a coquetear con el uso de la IA en la sustanciación de sus decisiones. La primera impresión de este tipo de decisiones para algunos sectores de la sociedad, sobre todo para el de la profesión de abogado, estas decisiones incurren en imprecisiones y en un uso tildado de “irresponsable” de un modelo de lenguaje a escala, es decir, una herramienta no especializada en asuntos jurídicos sino con aspiraciones generalistas. A la par, muchos creen que el juez “nunca” sería remplazado por máquinas que no saben “razonar”, “ponderar”, ni “entender sutilezas”.

A raíz de lo anterior, algunos académicos y operadores jurídicos han reaccionado para contrarrestar la amenaza, bien sea con vehementes llamados a la limitación o regulación. Aunque, puede entenderse como una forma de auto regularse cuando hacemos referencia a la rendición de cuentas en los sistemas de IA y sus dificultades que tienen.

“El problema de la rendición de cuentas es aún más serio con los sistemas de IA que se basan en el aprendizaje automático. En este caso, la predicción se basa en algoritmos que cambian a lo largo del tiempo. Con el aprendizaje automático, los algoritmos “aprenden” (cambian) a partir de su propia experiencia. A medida que los algoritmos cambian, no sabemos cómo funcionan o porqué hacen cosas de cierta forma. Si no podemos implementar mecanismos efectivos de control, ¿cómo podemos garantizar una rendición de cuentas adecuada? El debate aún no se termina y el principio de precaución debe adoptarse hasta que estas preguntas hayan recibido una respuesta desde un punto de vista técnico e institucional.” (UNODC. Francesco Contini. (2019). Párr. 10)

No obstante, la asistencia de la IA en las funciones judiciales es una hipótesis ya contemplada en algunas regulaciones, incluso, en algunos casos hay una prohibición expresa de su uso. A modo de ejemplo de las mencionadas regulaciones, la Carta Ética Europea busca tener un control sobre la aplicación de la inteligencia artificial:

La Carta Ética Europea sobre el uso de la inteligencia artificial en los sistemas judiciales y su entorno es el primer instrumento europeo que establece cinco principios sustanciales

y metodológicos que se aplican al procesamiento automatizado de decisiones y datos judiciales, basados en técnicas de inteligencia artificial y que pueden guiar a los legisladores, legisladores y profesionales de la justicia cuando se enfrentan al rápido desarrollo de la inteligencia artificial en los procesos judiciales nacionales. (LegalToday. (2019). párr. 1)

“Sin embargo, la forma de implementar estas directrices todavía no está clara. Los abogados, las partes de la causa y los jueces definitivamente no pueden ser los responsables de llevar a cabo esa tarea.” (UNODC. Francesco Contini. (2019). Párr. 10)

En resumidas cuentas, se ha dicho que es muy pronto para permitir el uso indiscriminado de herramientas de IA en un campo tan delicado con la adjudicación de derechos y obligaciones en un marco contencioso. Al tratarse de una actividad de alto riesgo, convendría actuar con precaución frente a posibles daños que la IA pueda causar a la recta e imparcial administración de justicia.

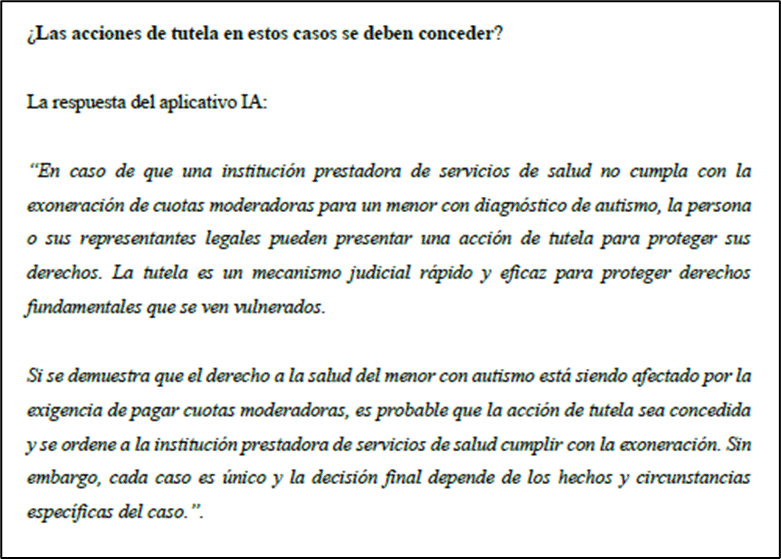

El debate se ha tornado más candente ahora que la Corte Constitucional ha resuelto revisar la sentencia del juez Juan Manuel Padilla García de Cartagena, en la que se concedió una tutela en la que se indicó haber usado ChatGPT para obtener información de consulta para la toma de decisiones. Obsérvese un extracto de la decisión asistida con ChatGPT.

(Juzgado 1 Laboral del circuito de Cartagena, 2023)

Todos estos llamados a la cautela tienen un fundamento sólido: el uso prudente de cualquier herramienta tecnológica (aunque realmente es predicable de cualquier herramienta en general) es imprescindible en todos los ámbitos de la actividad humana. Ahora bien, en particular, las herramientas de IA deben utilizarse responsablemente y con guías claras para evitar el denominado ‘abuso de la máquina’. Después de todo, si seguimos la línea de Terminator, los humanos llegamos a Skynet (la súper poderosa y malvada IA que pretendía dominar el mundo) por la excesiva confianza en la IA (lo que en ingles se conoce como overreliance).

Imagen de Skynet. Tomada de: https://i0.wp.com/imgs.hipertextual.com/wp-content/uploads/2022/01/Skynet-Inteligencia-Artificial.jpg?resize=768%2C432&quality=50&strip=all&ssl=1

Ahora, ¿Todo esto da para considerar que el uso de las herramientas como ChatGPT deban, por lo pronto, proscribirse, censurarse o limitarse en manos de jueces o sus auxiliares en despachos judiciales? Al mejor estilo de nuestro entrañable T-800 en la película, y con luces tomadas del IA Act Artificial expedido el 8 de junio de 2023 por la Unión Europea, a continuación presentaré algunas ideas de cómo utilizar herramientas de IA generativa – como ChatGPT – de manera adecuada.

Imagen del robot con justicia. Tomada de: https://lajusticiadigital.com/wp-content/uploads/2023/07/softplanplanejamentoesistemasltda_softplan_image_770-768×489.jpeg.webp

1. Si el uso es transparente, no hay deshonestidad

Lo primero que debe hacer cualquier funcionario judicial (llámese magistrado, juez, auxiliar, sustanciador, árbitro o servidor de la rama ejecutiva con funciones jurisdiccionales) es indicar de manera expresa que está haciendo uso de IA.

(Juzgado 1 Laboral del circuito de Cartagena, 2023)

(Juzgado 1 Laboral del circuito de Cartagena, 2023)

En este caso, el juez laboral de Cartagena indicó expresamente que iba a hacer uso de IA y citó el texto autogenerado entre comillas y en letra cursiva. Esto es una buena práctica y es lo recomendable, ya que se está citando un texto que no proviene directamente del autor de la decisión judicial. Si se parafrasea el texto de IA, también es importante indicarlo, por lo menos en un pie de página.

Guardar silencio o hacer pasar el texto como propio induce a las partes, sus abogados, otros funcionarios judiciales y, en general, a la ciudadanía a error.

2. Si el uso es responsable, no hay credulidad

La IA de Modelos de Lenguaje Masivos (o LLM, por sus siglas en inglés) avanza a pasos agigantados. Es sorprendente la capacidad que tienen estas herramientas de procesar cantidades masivas de información y dar respuestas plausibles a consultas en lenguaje corriente.

No obstante, por ello las herramientas son infalibles. En particular, la ausencia de modelos de IA entrenados específicamente con datos del ordenamiento jurídico colombiano impide que las respuestas a consultas jurídicas sean 100 % confiables. Naturalmente, como con cualquier fuente de investigación jurídica (y más, una todavía susceptible de errores) debe contrastarse con otras o con el conocimiento experto del autor. En otras palabras, no se puede confiar ciegamente en lo producido por una IA, sino que es menester realizar un proceso diligente y cauteloso de validación de la información generada por la herramienta.

El uso responsable es, pues, tener claro que los modelos de lenguaje natural no son un oráculo de sabiduría incuestionable y que sus respuestas deben ser verificadas por el ser humano que los utiliza. El juez que hace uso de estas herramientas no puede caer en la credulidad o en la excesiva confianza (overreliance).

Por otro lado, un modelo LLM como ChatGPT no esté especializado en resolver casos jurídicos concreto, pero da una idea al respecto. Se puede evidenciar que no se trata de una IA que desbocada tomando decisiones judiciales a diestra y siniestra, se entiende que es un texto que termina siendo de autoría de un ser humano por referencia directa, por tanto, los jueces responden por su cita.

Si el juez copia mal el texto o el texto citado desconoce las fuentes del derecho, el juez humano se somete a que su decisión sea revocada. Para eso tenemos un sistema judicial de controles internos a través de recursos como la apelación o la revisión en el caso de una tutela. Incluso el mismo de la IA se somete al riesgo que sucedan errores, tales como sucedió en Brasil, cuando erró al redactar una sentencia.

Examinemos bajo esta perspectiva el uso que le dio la magistrada del Tribunal Administrativo del Magdalena al ChatGPT en el auto por el que citó a una audiencia en el metaverso:

(Tribunal Administrativo del Magdalena, 2023)

En este caso, la magistrada usó la herramienta para extraer una definición técnica y citó ese uso. Si bien no es explicito que haya contrastado dicha definición con otras fuentes, tampoco nos atrevemos a afirmar que en su análisis no haya hecho esta comparación. A pesar de ello, es recomendable dejar la constancia expresa de la validación de la información.

En fin, no veo que, al aludir expresamente a ChatGPT en sus decisiones, los jueces asuman la IA como un oráculo, pareciera que creemos que la IA tiene la verdad absoluta. Cuando hacemos referencia expresa al ChatGPT y entrecomillar los textos de IA generativa, los jueces hacen suya una cita, como si fuera de un tratado, una sentencia u otra fuente del derecho, y asumen responsabilidad por ello.

3. Si el uso es ético, no hay mal ejemplo

La “Recomendación sobre la ética en la IA” adoptada por la UNESCO en el 2021 nos da una guía sobre los usos de la IA que se consideran éticos en el ámbito público (UNESCO, 2021). (i) En lo que concierne a la función judicial, se expresa que, quien use la IA, debe beneficiar a su ciudadano (ii), debe tener un fin jurídico razonable y proporcional (iii), no debe discriminar, y por el contrario contario, ha de promover la justicia algorítmica (iv), debe cumplir con la ley (v); y debe estar sujeta al control humano.

Veamos el caso del juez de Cartagena que, por tratarse de una tutela, implicaba una afectación de derechos fundamentales:

(Juzgado 1 Laboral del circuito de Cartagena, 2023)

En este caso, el juez le pidió al ChatGPT que le diera una idea de la línea jurisprudencial de la Corte Constitucional en materia de derechos de personas en condición de discapacidad.

ChatGPT dio una respuesta razonable, que el juez validó con su propio criterio y conocimiento. En esa medida, el uso de ChatGPT:

- Benefició a las partes procesales pues le permitió al juez arribar a una decisión conforme a derecho;

- Persiguió el fin razonable y proporcional de lograr una resolución pronta conforme al principio de la economía procesal;

- Promovió la justicia algorítmica pues reivindicó los derechos de la parte que el juez consideró violados;

- Cumplió con la ley, dado que la ley colombiana explícitamente insta a los jueces a implementar la tecnología, tal como se contempla en el artículo 2 de la Ley 2213 de 2022, según el cual “Se podrán utilizar las tecnologías de la información y de las comunicaciones, cuando se disponga de los mismos de manera idónea, en la gestión y trámite de los procesos judiciales y asuntos en curso, con el fin de facilitar y agilizar el acceso a la justicia […]” (Ley 2213, 2022, art 2)

- Estuvo sujeto al control humano pues el juez no defirió la decisión a la IA; sino que lo utilizó para consulta.

Si miramos el resultado y la conducta del juez no vemos una conducta antiética. No lo era en el momento en que lo hizo, y mucho menos lo podemos reprochar con espejo retrovisor ahora.

- Si el uso genera eficiencia y valor agregado, el resultado debe verificarse por su contenido y no por su origen

En todo proceso legal en el que se haga uso de tecnología, es clave ver si la tecnología agrega valor a la labor de quien la utiliza. Si genera más trabajo, simplemente no cumple su fin y debe rediseñarse o desecharse.

Apliquemos este postulado a la tutela del juez de Cartagena. Ante todo, la Corte debería evaluar el fondo de la decisión y no la forma. ¿Tiene la Corte herramientas para decir que la decisión fue incorrecta o contraria a derecho?

Incluso si la cita es imprecisa, ¿se invalida toda la decisión del juez por ese solo hecho? ¿No se le podría dar el beneficio de la duda de que sí le ayudó a tomar la decisión, como si hubiera investigado el tema con una base de datos jurídica y la cita fuera imprecisa?

Richard Susskind, uno de los grandes visionarios de la profesión jurídica sugiere que la clave es centrarnos en el resultado; no en el origen de la decisión (Susskind, 2023). Si el resultado es aceptable -como lo juzgaríamos si fuera emitido totalmente por un ser humano-; no deberíamos (ni tendríamos como) desestimarlo. {

Es innegable que estamos viviendo en una era donde los algoritmos y la inteligencia artificial están tomando decisiones que impactan nuestras vidas diarias, desde cuestiones de seguros de salud hasta subsidios gubernamentales. La automatización de decisiones ya es una realidad.

La gran incógnita radica en determinar si estas decisiones son efectivamente mejores que las que tomaría un ser humano. Si la IA logra resultados superiores a los de un juez promedio (aunque por ahora esto parezca ser una excepción), ¿no deberíamos considerarla válida solo porque proviene de un algoritmo? Más allá del uso ético o inapropiado que se le dé a la IA, es crucial comparar la decisión final con la que tomaría un ser humano en una situación similar.

No podemos ignorar que los humanos estamos inherentemente influenciados por sesgos, algunos de los cuales nos llevan a tomar decisiones discriminatorias. Es por eso que a menudo nuestras decisiones están sujetas al escrutinio de otros individuos, como en procesos de apelación o revisiones legales.

La verdad es que los sesgos y las malas decisiones son parte inherente de nuestra naturaleza humana (como dice el famoso aforismo, ‘errare humanum est’). Muchos de nuestros atajos mentales, la mayoría de ellos inconscientes, fueron esenciales para la evolución de nuestra especie. Algunos argumentan que el rechazo a lo diferente fue en su momento una medida evolutiva para proteger a nuestro grupo cercano, pero este sesgo ha generado problemáticas sociales como el racismo. En resumen, nuestros sesgos nos hacen ser decisores notablemente imperfectos.

Y estos sesgos, curiosamente, también se filtran en los modelos que alimentan los sistemas de IA. Es evidente que el sesgo humano puede traspasarse desde su creador, el programador, hacia la herramienta misma. Con la IA, es posible crear modelos que no sean neutrales y que reproduzcan las inclinaciones de sus creadores o de los datos que los alimentan

5. Prohibir ¿para qué…?

Por último, la prohibición o la censura frente al uso de la IA generativa sirven solo para el propósito opuesto. Los jueces continuarán usando el ChatGPT, pero, por miedo a la censura, se abstendrán de hacerlo de manera transparente.

Es evidente que la inteligencia artificial es mucho más que una sola tecnología; es un conjunto diverso de herramientas que se nutren de la automatización y el aprendizaje continuo, y muchas de estas herramientas aún están por descubrirse, más allá de plataformas como ChatGTP. Como tecnología, la IA está destinada a evolucionar a un ritmo considerablemente más rápido que los seres humanos.

Por lo tanto, debemos sopesar las decisiones tomadas por humanos y las decisiones algorítmicas, considerando sus respectivas ventajas y sesgos, y adoptar aquella que beneficie más a la sociedad en su conjunto. ¿No sería irracional desestimar una decisión judicial fundamentada en un algoritmo que ofrece mayor objetividad y seguridad jurídica que la de un juez humano?

Una crítica tan severa en un estado incipiente del arte puede llevar a restricciones demasiado prontas en el uso de la tecnología con un potencial magnífico para la administración de justicia. ¡Y la inteligencia artificial sí que nos puede ayudar!

La disrupción de los jueces colombianos no debe penalizarse y menos con una mirada retroactiva con estándares que aún no se han consolidado, debemos de reconocer que las IA están impregnando en nuestra vida, por ende, rechazar la realidad es condenarnos a estancarnos en una mentira, hay que hacer su debido reconocimiento y ajustes.

6. ¿Terminator con toga?

Para la cronología de Terminator, en el 2023, las máquinas exterminadoras ya se habían tomado la humanidad. Paradójicamente, en el filme, solo la inteligencia artificial tenía la capacidad librarnos de sí misma. Skynet, ese poderoso algoritmo, iba a iniciar el “juicio final” -un holocausto sin precedentes que nos pondría a la merced de máquinas aterradoras- y un Terminator programado por humanos era nuestra única ayuda.

El llamado es a usar mejor la herramienta o a adoptar herramientas mejores que ChatGPT. El futuro es ahora.

Pero Terminator, al fin y al cabo, es solo ciencia ficción. El uso de la inteligencia artificial es otra actividad humana que debemos comprender y no temer.

Referencias:

Cameron, James. (1991). Terminator 2: EL juicio final. [Película]. Studio Canal.

Congreso de Colombia (13 de junio de 2022). Artículo 2. Ley sobre medidas para

implementar las tecnologías de la información y las comunicaciones en las actuaciones judiciales. [Ley 2213 de 2022]

Corte Superior de Justicia de Lima sur. (27/03/2023).

Expediente-00052-2022-18-3002-JP-FC-01-LPDerecho.pdf

Imagen de Skynet. Tomada de:

Imagen del robot con justicia. Tomada de:

Juzgado 1 Laboral del circuito de Cartagena. (30/01/2023). Sentencia No 32.

Radicado N° 13001410500420220045901. Sentencia Cartagena IA.pdf

LegalToday. (2019). El Consejo de Europa adopta la primera Carta Ética Europea sobre el

uso de inteligencia artificial en los sistemas judiciales. https://www.legaltoday.com/legaltech/nuevas-tecnologias/el-consejo-de-europa-adopta-la-primera-carta-tica-europea-sobre-el-uso-de-inteligencia-artificial-en-los-sistemas-judiciales-2019-01-10/

Tribunal Administrativo del Magdalena. (10/02/2023). Radicado.

47-001-2333-000-2020-00014-00. [MP. Maria Victoria Quiñones Triana]. https://drive.google.com/viewerng/viewer?url=https://embeber-pdf-arc.s3.amazonaws.com/Auto-2020-014-Trib-Advo-Metaverso-1676321215206.pdf

Susskind, R. (2023). Tomorrow´s Lawyers. Oxford. Third Edition.

UNESCO. (2021). Ética de la inteligencia artificial.

UNODC. (2019). La inteligencia artificial: ¿un nuevo caballo de Troya que influye indebidamente en el poder judicial? https://www.unodc.org/dohadeclaration/es/news/2019/06/artificial-intelligence_-a-new-trojan-horse-for-undue-influence-on-judiciaries.html

Artículos Recientes

¡Ya está disponible el caso! Segunda versión del Concurso Laboratorio de Estrategia Legal #LSL

Invitamos a los estudiantes de pregrado y postgrado de todas las carreras a presentar [...]

Masterclass Legal Operations: Transformando la Función Legal Empresarial de Guardián de Riesgos a Creador de Valor.

El Departamento de Derecho de los Negocios y la Facultad de Administración de Empresas [...]

Conclusión del Proceso de Reforma al Investor-State Dispute Settlement

En la semana del 12 de julio de 2023, durante la sesión anual de [...]

El Departamento de Derecho de los Negocios de la Universidad Externado de Colombia abre convocatoria para la vacante de Asistente de Investigación

¡Sé parte de nuestro equipo de trabajo! Perfil del cargo: Asistente de Investigación Apoyar [...]

Docente del Departamento de Derecho de los Negocios participó en el libro Blanco de la Asociación de Derecho Internacional

La Asociación de Derecho Internacional (ADI), una de la organizaciones más antiguas y prestigiosas [...]

CRYPTO IN COLOMBIA: PROSPECTIVE 2022

By: Daniel Peña Valenzuela The volatility of the main cryptocurrencies seems to be once [...]

Convocatoria de Monitores.

El Departamento de Derecho de los Negocios se complace en anunciar la apertura para [...]

¿Se avecina una regulación de la Franquicia por parte del Gobierno? ¿O lo impedirá la Corte Constitucional?

Por: Juan Miguel Álvarez* y Diana Marcela Araujo* En diciembre del 2020, el congreso [...]

Ciclo de seminarios de Innovaciones en Justicia Digital: un espacio desde la academia que replantea el futuro del sistema de justicia.

El Seminario en Innovaciones en Justicia Digital es un evento de la Universidad Externado [...]

Rostros de mentira: Retos legales producidos por las ‘Deepfakes’

Palabras clave: Deepfake, IA, contenidos audiovisuales, redes generativas adversarias, derecho probatorio, intimidad personal. Una [...]

Memorias: Tercer seminario de innovaciones en la justicia digital- aplicaciones de la inteligencia artificial en la práctica judicial.

El pasado 19 de septiembre de 2024, las instalaciones de la Universidad Externado fueron [...]

Celebramos la realización del 40º Congreso Nacional de Derecho Comercial: Novedades y retos de la contratación mercantil y del arbitraje comercial

El pasado 30 de octubre, en Medellín, se celebró el 40º Congreso Nacional de [...]